这些产品将与谷歌的TPU竞赛,不同的是,英特尔支撑愈加广泛的学习结构。

原标题:英特尔初次发布AI加快器芯片 脸书已运用百度参加开发

新京报讯(记者 梁辰)8月22日,英特尔发布了行将推出的两款针对大型数据中心规划的处理器,这是该公司初次发表高功能人工智能加快器产品。

这两款芯片是Nervana神经网络处理器系列产品,其间一款用于练习,另一款用于推理,这是人工智能算法构成的两个关键环节。2016年8月,英特尔收买美国创业公司Nervana Systems,随后将其与本身事务整合,并追加3.5亿美元的投入,用于研制和本身产品匹配。

不仅如此,英特尔还表明,这些产品是近两年在出资了以色列人工智能公司Habana Labs和NeuroBlade后推出的。Habana Labs的解决计划Goya功能优于现在数据中心常用计划的1到3个数量级,而NeuroBlade的优势在于降低成本和功耗。

与通用芯片不同,人工智能专用加快器着重的是恰当的时刻供给给适宜的智能。英特尔全球副总裁兼人工智能产品事业部总经理Naveen Rao表明,针对杂乱的人工智能运用,数据中心和云端需求供给通用核算以及专门的加快。

英特尔发表用于练习的NNP-T能够进行定制,以便加快各种负载,而用于推理的NNP-I运用10纳米制程技能提高了每瓦功能。事实上,这些产品将与谷歌的TPU、英伟达以及亚马逊AWS自研芯片竞赛。

与专为谷歌机器学习结构TensorFlow规划的TPU不同,英特尔的产品支撑百度、Facebook以及谷歌等提出的干流机器学习结构。2019年7月,Naveen Rao曾在百度人工智能开发者大会上宣告,为了提高练习模型速度两边合作开发处理器产品。此次英特尔发布产品时还宣告,Facebook正在运用这些产品。

新京报记者 梁辰修改程波校正李世辉

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量”

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量” “千翼飞舞天际 5G闪耀广州”2023数字科技生态大会 11月10日中国·广州

“千翼飞舞天际 5G闪耀广州”2023数字科技生态大会 11月10日中国·广州 情人节不止214 DR钻戒将七夕情人节传至海外

情人节不止214 DR钻戒将七夕情人节传至海外 华为智选x膳魔师强势合作,致力于联力打造智能水杯标杆

华为智选x膳魔师强势合作,致力于联力打造智能水杯标杆 东方企业创新发展中心与淮安举行战略合作签约仪式

东方企业创新发展中心与淮安举行战略合作签约仪式 亿达科创出席国字盛会 共话数字贸易高质量发展

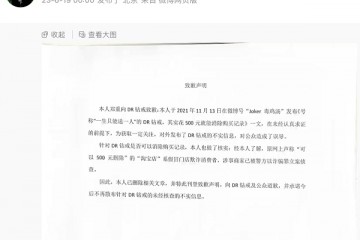

亿达科创出席国字盛会 共话数字贸易高质量发展 “DR购买记录可删”被证实是谣言,传谣者向DR和公众道歉

“DR购买记录可删”被证实是谣言,传谣者向DR和公众道歉 2023上交会:亿达科创以“数字”引擎 释放绿色发展动能

2023上交会:亿达科创以“数字”引擎 释放绿色发展动能