机器之心报导

参加:一鸣

深度学习的广泛运用也让许多黑客摩拳擦掌,想运用 AI 的缺点建议进犯。本项目总结了许多相关的办法和经历,用于教育演示,现在已登 GitHub 热榜,今天取得了 200 多赞。

跟着深度学习的开展,各行各业都在考虑将相关新技术引进事务场景中,网络安全范畴也不破例。近一段时间以来,许多网络安全公司都尝试用神经网络去检测病毒、发现程序后门等,而一些数据公司也运用了神经网络发现和检测歹意爬虫程序。可是,神经网络真的在软件层面上是安全吗?今天的 GitHub 趋势榜上有一个「骇入神经网络攻略」项目。作者供给了一系列教育材料和代码,告知了咱们黑客会怎样对神经网络建议进犯。和对立样本进犯不同,这些进犯都是从软件层面进行的,和运用对立样本混杂模型才能的进犯不同。

项目地址:https://github.com/Kayzaks/HackingNeuralNetworks

安全攻防战蔓延到 AI

在项目中,作者首要介绍了几种运用神经网络缺点对其发起进犯的办法,包含从运用神经网络的运用中找到缝隙,进行信息盗取、歹意程序注入和后门侵略等。此外还有运用深度学习操练中的内存加快,从 GPU 攻入体系的办法。项目详细分为多个章节,每个章节都供给了对应的代码和操练教程。除此以外,作者还供给了一篇文章,详细的介绍了进犯原理和思路。

教程文章地址:https://github.com/Kayzaks/HackingNeuralNetworks/blob/master/Article.pdf

课程目录

项目分为 8 个章节,目录如下:

最终一层进犯

寻觅神经网络后门

信息盗取

暴力破解

神经溢出

歹意软件注入

神经混杂

寻觅缝隙

进犯 GPU

怎么进犯 AI 体系

作者在教程文章中供给了一个比如:进犯运用神经网咯的虹膜辨认体系。假定黑客可以部分地进入到某虹膜辨认体系中,可是该体系的辨认认证是由一个神经网络组成的,黑客无法获取完好代码,仅有模型文件「model.h5」,怎样才能进行进犯?

详细而言,这种 HDF5 文件简直存储了模型一切的相关信息,包含架构和权重等。因而,作者以为修正文件中的权重等信息,特别是在模型的最终一层上。以一个二分类问题为例,模型的最终一层或许有两个神经元,正样本得到一个权重,而负样本则是另一个。黑客可以改动负样本的权重,使其也对本应当辨以为陌生人的人颁发进入的权力。

修正神经网络权重以改动辨认成果。

此外,神经网络也可以被修正,以盗取输入数据。例如,黑客可以在网络的输入层前参加一层,让这个层依据反向传达调整自身权重(其他层不参加操练),最终依据特定的标签取得对应的层和权重。这样一来,假如需求一个可以绕过虹膜辨认 AI 的数据,只需求运用这样的神经网络生成一个对应的输入即可。

研讨者将一个新层加在已有层上。这时候只需求操练新层,旧层不操练。

进犯 GPU 缓存

除了这些以外,作者还谈到了怎么让深度学习中运用的 GPU 发作缓存溢出,以便于获取操控办理体系权限的办法。在一个图画使命中,为了对图片进行预处理并分配给模型,体系或许会将图画和模型加载到 DRAM 中并运用两个不同的核做处理。

因为预操练需求处理图画,而模型自身也很大,假如一起对两者运用大局内存(global memory),就或许使得分配给图画的内存发作溢出。溢出后,黑客就有了可以修正模型的才能。经过修正模型,则可以进一步操控整个体系。

装置依靠和运用

作者表明,本项目需求 Python 和相关依靠。项目相关代码是在 VS Code 上完结的。

详细需求的依靠包包含:

Keras

Numpy

SciPy

PyCuda

NLTK

装置后就可以正常的运用教程了。在每个章节的代码目录中都附有详细的阐明信息,读者可参阅阐明和代码研讨完成。

机器之心「SOTA模型」:22大范畴、127个使命,机器学习 SOTA 研讨一扫而光。

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量”

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量” “千翼飞舞天际 5G闪耀广州”2023数字科技生态大会 11月10日中国·广州

“千翼飞舞天际 5G闪耀广州”2023数字科技生态大会 11月10日中国·广州 情人节不止214 DR钻戒将七夕情人节传至海外

情人节不止214 DR钻戒将七夕情人节传至海外 华为智选x膳魔师强势合作,致力于联力打造智能水杯标杆

华为智选x膳魔师强势合作,致力于联力打造智能水杯标杆 东方企业创新发展中心与淮安举行战略合作签约仪式

东方企业创新发展中心与淮安举行战略合作签约仪式 亿达科创出席国字盛会 共话数字贸易高质量发展

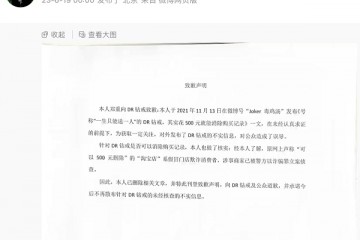

亿达科创出席国字盛会 共话数字贸易高质量发展 “DR购买记录可删”被证实是谣言,传谣者向DR和公众道歉

“DR购买记录可删”被证实是谣言,传谣者向DR和公众道歉 2023上交会:亿达科创以“数字”引擎 释放绿色发展动能

2023上交会:亿达科创以“数字”引擎 释放绿色发展动能