关于剪枝技能,你了解多少?这里有一份秘籍,整理了 2019 年度的 6 篇论文所说到的最新剪枝办法。

剪枝是一种协助神经网络完结规划更小、功率更高的深度学习办法。这是一种模型优化技能,它删去权重张量中不必要的值,然后使得紧缩后的神经网络运转速度更快,网络练习进程中的计算本钱也有所下降。在将模型布置到手机等边际设备上时,剪枝的效果愈加明闪现。

本篇精选了神经网络剪枝范畴的一些研讨论文,供咱们学习参阅。

论文 1:Pruning from Scratch (2019)

作者提出了一种从头开始剪枝的网络剪枝流程。他们在 CIFAR10 和 ImageNet 数据集上对多个紧缩分类模型进行了试验,成果表明该流程下降了正常剪枝办法的预练习开支,一起进步了网络的准确率。

论文链接:https://arxiv.org/pdf/1909.12579.pdf

下图展现了传统剪枝流程的三个阶段:预练习、剪枝和微调。

这篇论文提出的剪枝技能包括可依据随机初始化权重学得的新的剪枝流程。通道重要性(channel importance)则可经过相关标量门控(scalar gate)值和每个网络层来学得。

优化通道重要性,可在稀少性正则化的情况下进步模型功能。在此进程中,随机权重并未得到更新。然后,依据给定资源束缚,运用二分查找战略确认剪枝后模型的通道数装备。

下表展现了模型在不同数据集上的准确率:

论文 2:Adversarial Neural Pruning (2019)

这篇论文首要讨论在遇到对立扰动时网络隐特征的失真问题。该论文提出的办法是:学习贝叶斯剪枝掩码,来按捺较高档的失真特征,然后最大化其面临对立扰动的稳健性。

论文链接:https://arxiv.org/pdf/1908.04355.pdf

作者考虑了深度神经网络中隐特征的软弱性。该办法提出剪除软弱的特征,一起保存稳健的特征。这一进程可经过在贝叶斯结构中对立地学习剪枝掩码来完结。

对立神经剪枝(Adversarial Neural Pruning,ANP)结合了对立练习和贝叶斯剪枝办法。该论文提出的新模型及其基线模型是:

规范的卷积神经网络(Standard)

运用贝塔-伯努利 dropout(beta-Bernoulli dropout)的 base 网络,即贝叶斯剪枝(BP)

对立练习网络(AT)

运用贝塔-伯努利 dropout 的对立神经剪枝(ANP)

运用软弱按捺丢失(vulnerability suppression loss)进行正则化得到的对立练习网络(AT-VS)

运用软弱按捺丢失进行正则化得到的对立神经剪枝网络(ANP-VS)

下表展现了模型的功能:

论文 3:Rethinking the Value of Network Pruning (ICLR 2019)

这篇论文提出的网络剪枝办法分为两类,方针剪枝模型的架构由人类或剪枝算法来决议。在试验中,作者比照了从头开始练习剪枝模型和依据承继权重进行微调得到的剪枝模型的成果,该比照针对预界说办法和主动化办法。

论文链接:https://arxiv.org/pdf/1810.05270v2.pdf

下图展现了运用依据 L1 范数的滤波器剪枝的预界说结构化剪枝所得到的成果。每一层都运用较小的 L1 范数剪掉必定份额的滤波器。「Pruned Model」列是用于装备每个模型的预界说方针模型列表。咱们咱们能够看到,每一行中,从头开始练习的模型功能至少与微调模型相等。

如下表所示,ThiNet 贪婪地剪去了对下一层的激活值影响最小的通道。

下表展现了依据回归的特征重建办法的成果。该办法最小化了下一层的特征图重建差错,然后完结对通道剪枝。该优化问题能够终究靠 LASSO 回归处理。

至于 Network Slimming,在练习进程中,对批归一化层中的通道级缩放因子施加 L1 稀少性。之后,运用较低的缩放因子对通道剪枝。因为通道缩放因子经过跨层比照,因而该办法能取得主动发现的方针架构。

论文 4:Network Pruning via Transformable Architecture Search (NeurIPS 2019)

这篇论文提出了直接对具有灵敏通道数和层数的网络运用神经架构查找。完结剪枝网络的丢失最小化有利于学习通道数。剪枝网络的特征图由依据概率散布采样的 K 个特征图片段组成,经过反向传达将丢失传输到网络权重和参数化散布。

论文链接:https://arxiv.org/pdf/1905.09717v5.pdf

剪枝网络的宽度和深度是依据每个散布规划的最大概率得来的,然后经过从原始网络进行常识迁移来获取这些参数。论文作者在 CIFAR-10、CIFAR-100、ImageNet 数据集上评价了该模型。

该剪枝办法包括三个过程:

用规范分类练习过程练习未经剪枝的大规划网络;

经过 Transformable Architecture Search (TAS) 查找小规划网络的深度和宽度,旨在查找最佳规划的网络。

用简略的常识蒸馏(KD)办法,将未经剪枝网络的信息迁移到查找得到的小规划网络中去。

下表比照了不同 ResNet 模型经过不同剪枝算法后,所得到的模型在 ImageNet 数据集上的各自体现:

论文 5:Self-Adaptive Network Pruning (IConIP 2019)

这篇论文提出经过自适应网络剪枝办法(SANP)下降 CNN 的计算本钱,经过对每个卷积层引进 Saliency-and-Pruning Module (SPM) 来完结,SPM 模块能够学习猜测显著性分数,并对每个通道剪枝。SANP 会依据每个层和每个样本决议对应的剪枝战略。

论文链接:https://arxiv.org/pdf/1910.08906.pdf

依据下面的架构图,SPM 模块嵌入在卷积网络的每个层中。该模块能够依据输入特征去猜测通道的显著性分数,然后为每个通道生成对应的剪枝决议计划。

关于剪枝决议计划为 0 的通道,则越过卷积运算,然后运用分类方针和本钱方针联合练习主干网络和 SPM 模块。计算本钱取决于每一层的剪枝决议计划。

下表展现了该办法的一些成果:

论文 6:Structured Pruning of Large Language Models (2019)

这篇论文提出的剪枝办法依据低秩分化和增强拉格朗日 L_0 范数正则化(augmented Lagrangian 10 norm regularization)的原理。L_0 正则化放宽了结构化剪枝带来的束缚,而低秩分化则保存了矩阵的密布结构。

论文链接:https://arxiv.org/pdf/1910.04732.pdf

正则化让网络去挑选待移除的权重。权重矩阵被分化为两个较小的矩阵,然后设置这两个矩阵之间的对角线掩码(diagonal mask)。在练习进程中,运用 L_0 正则化对该掩码履行剪枝。增强拉格朗日办法用于操控模型的终究稀少程度, 论文作者将该办法叫做 FLOP (Factorized L0 Pruning)。

论文运用的字符级言语模型用在 enwik8 数据集的试验中,该数据集包括选取自维基百科的 100M 数据。作者在 SRU 和 Transformer-XL 模型上评价了 FLOP 办法。下表展现了部分成果:

以上便是本次为咱们介绍的几种剪枝技能,本文介绍的论文也有代码完结,你们能够亲身测验。

本文为机器之心编译,转载请联络本大众号取得授权。

------------------------------------------------

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量”

全国人大代表刘宏志:推动数字乡村建设、激发乡村振兴“数智力量” “千翼飞舞天际 5G闪耀广州”2023数字科技生态大会 11月10日中国·广州

“千翼飞舞天际 5G闪耀广州”2023数字科技生态大会 11月10日中国·广州 情人节不止214 DR钻戒将七夕情人节传至海外

情人节不止214 DR钻戒将七夕情人节传至海外 华为智选x膳魔师强势合作,致力于联力打造智能水杯标杆

华为智选x膳魔师强势合作,致力于联力打造智能水杯标杆 东方企业创新发展中心与淮安举行战略合作签约仪式

东方企业创新发展中心与淮安举行战略合作签约仪式 亿达科创出席国字盛会 共话数字贸易高质量发展

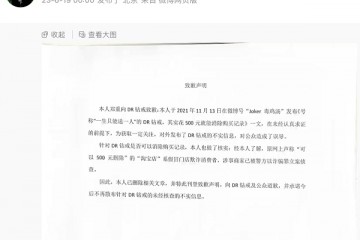

亿达科创出席国字盛会 共话数字贸易高质量发展 “DR购买记录可删”被证实是谣言,传谣者向DR和公众道歉

“DR购买记录可删”被证实是谣言,传谣者向DR和公众道歉 2023上交会:亿达科创以“数字”引擎 释放绿色发展动能

2023上交会:亿达科创以“数字”引擎 释放绿色发展动能